Data & Analytics-Lösungen generieren aus Daten Wissen und bilden die Grundlage fundierter betrieblicher Entscheidungen.

von Roland Abele

Auch wenn wir sie nicht erkennen: Künstliche Intelligenz (KI) steckt bereits heute in unglaublich vielen Software-Produkten, etwa in der Bilderkennung und in Sprachassistenten wie Siri oder Alexa. Die von Unternehmen weltweit geforderte Digitalisierung und digitale Transformation beschleunigen nun die Einführung neuer Technologien in Industrie, Handel, Dienstleistung und Logistik immer stärker. Künstliche Intelligenz, Virtual und Mixed Reality sowie das Internet of Things (IoT) sind aus dem Unternehmensumfeld selbst in traditionellen Betrieben kaum noch wegzudenken.

So lassen Digitalisierung und digitale Transformation den ohnehin schon hohen Datenberg rasant wachsen. Aber genau darin verbergen sich auch die Schlüssel zum Unternehmenserfolg: Mit Methoden und Lösungen aus dem Bereich Data & Analytics lassen sich die in der riesigen Datenmenge enthaltenen Informationen extrahieren, um Wissen aufzubauen und eine fundierte Grundlage für betriebliche Entscheidungen zu schaffen. Sie unterstützen damit jene Menschen, die in den Unternehmen täglich Entscheidungen treffen, und lassen sich zudem dafür nutzen, betriebliche Prozesse automatisiert zu steuern.

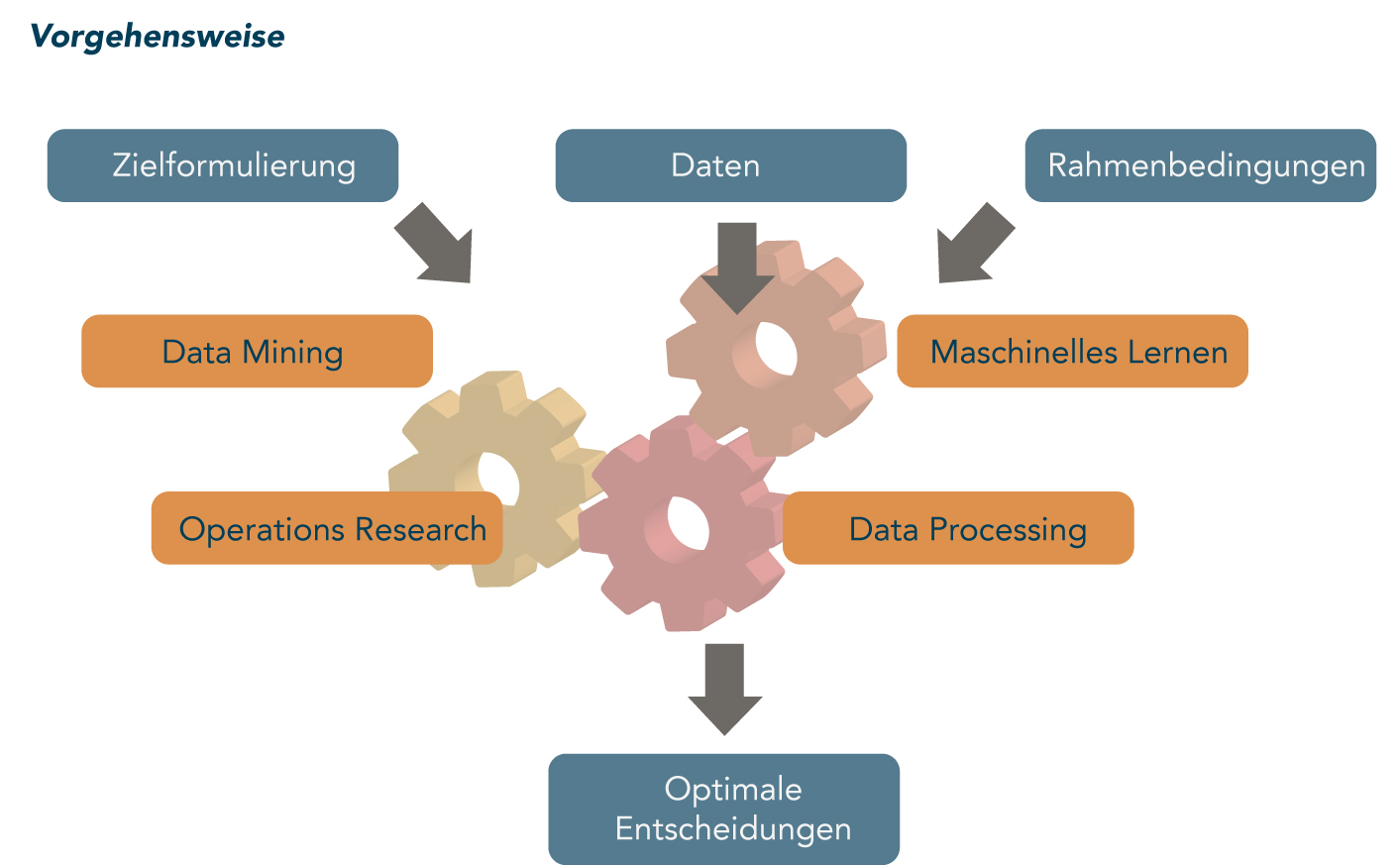

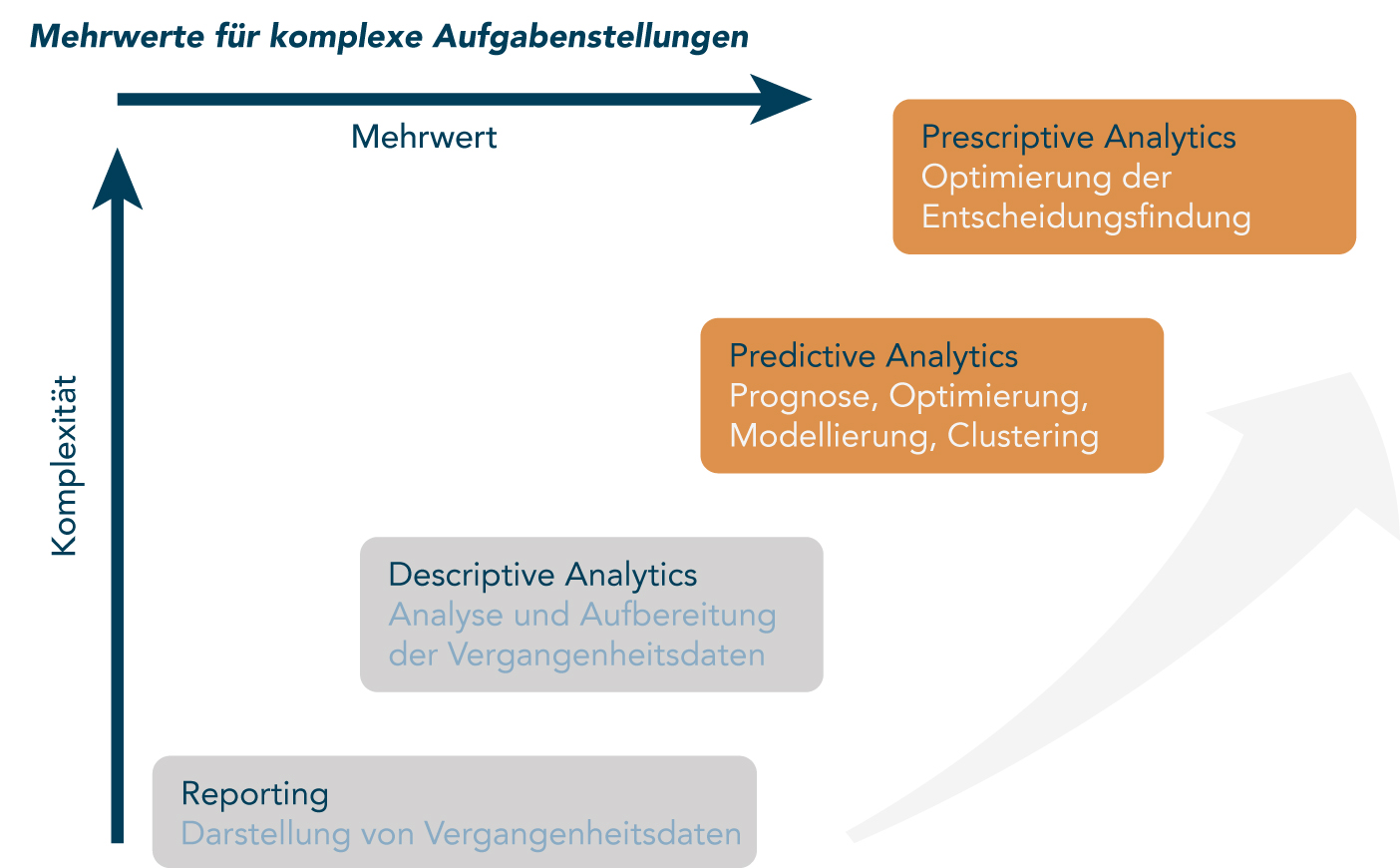

Der Bereich Data Science & Analytics ist bei der Cosmo Consult Data Science GmbH mit seinen Produkten und Leistungen darauf spezialisiert, Entscheidungen in komplexen, dynamischen Märkten zu optimieren. Dabei kommen sowohl erprobte Methoden als auch Eigenentwicklungen aus Bereichen wie Data Mining, Prognose oder Operations-Research zum Einsatz (Abb. 1). Die Kombination praxisbewährter Produkte und die jahrelange Erfahrung in der methodischen Umsetzung gewährleisten den Erfolg in Kundenprojekten.

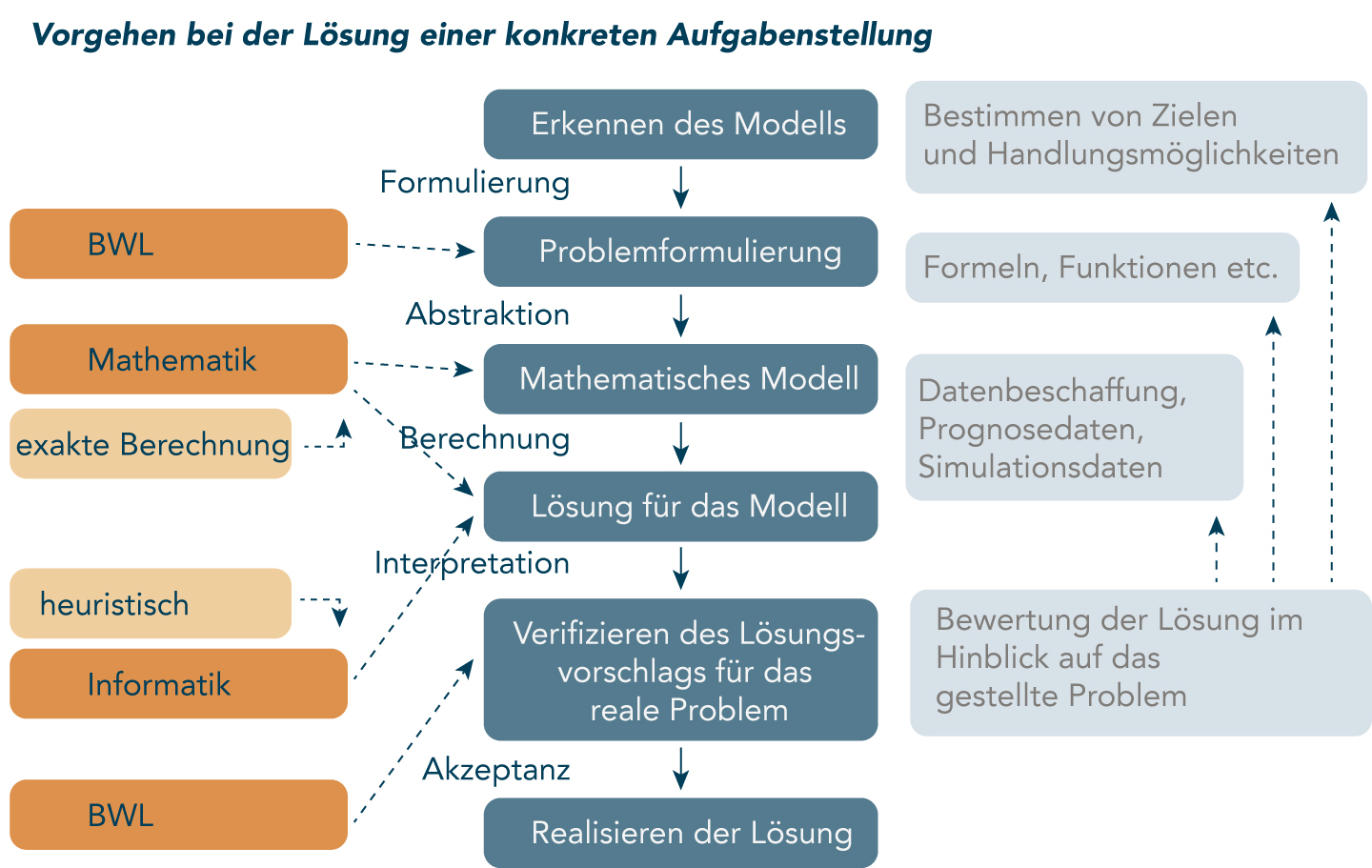

Für die künstliche Intelligenz besteht zwar ein großes Interesse, es fehlen allerdings noch ausreichend konkrete Anwendungsfälle. Allerdings nicht überall: Auf die Optimierung von betriebswirtschaftlichen Entscheidungen mit mathematischen Modellen haben wir uns spezialisiert. Dabei setzen wir neben erprobten Methoden und eigenen Entwicklungen auch Modelle aus Microsoft Azure ML ein. Die Modelle wurden auf konkrete Aufgabenstellungen ausgerichtet (Abb. 2) und umfassen Algorithmen des Data Mining und Predictive Analytics. Im Bereich der Entscheidungsoptimierung (Prescriptive Analytics) gibt es End-to-End-Lösungen – vom Aufbau der Strategie bis zur Verwirklichung – und die passenden Dienstleistungen. Ein ganzheitlicher Ansatz ermöglicht den flexiblen Einsatz in verschiedenen Branchen.

Intelligente Algorithmen zur Optimierung von Business-Entscheidungen

Ein professionelles Data Management vereinfacht, verwaltet und automatisiert die Integration der Daten – ganz gleich, ob sie aus internen oder externen Quellen stammen. Hierzu gehören etwa Unternehmens-, Maschinen-, Sensor- oder Kundendaten. Mit unseren Lösungen zum Data Management lassen sich Daten qualitativ prüfen, harmonisieren und für betriebliche Entscheidungsprozesse aufbereiten.

Die Data & Analytics-Lösungen dienen dazu, aus Daten Wissen zu generieren, um dem berühmtem Bauchgefühl fundierte Fakten zur Seite zu stellen. Selfservice-Strukturen wie Management-Dashboards können das Controlling entlasten und unterstützen zeitnahe Entscheidungen. Die beiden Segmente Data Management und Data&Analytics fasst man auch unter dem Fachbegriff „Business Intelligence“ zusammen.

Nach Data Management und Data & Analytics ist Data Science die nächste Stufe, um datengetriebene Prozesse im Unternehmen zu perfektionieren. Während Data&Analytics Zusammenhänge und Abhängigkeiten multidimensional analysiert, nutzt Data Science mathematische Regeln (Algorithmen), um Prozesse zu optimieren, Wahrscheinlichkeiten zu berechnen oder Vorhersagen zu treffen. Mit anderen Worten: Bei Data Science werden modernste Technologien wie Machine Learning und künstliche Intelligenz gezielt eingesetzt, um Prozesse zu optimieren oder zu automatisieren.

Data Science unterstützt Unternehmen mit folgenden Lösungen:

- Bei Data Acquisition geht es darum, die richtigen Datenquellen auszuwählen und auf Zuverlässigkeit, Qualität und Vollständigkeit zu prüfen. Nur valide Daten eigenen sich für mathematische Modelle, mit denen die Entscheidungsfindung optimiert wird. Das Ergebnis ist eine bereinigte Datengrundlage, die auch in aggregierter Form die Basis für mathematische Algorithmen stellt.

- Das Data Preprocessing bedeutet, die richtigen Daten auszuwählen, sie zu bereinigen und zur Weiterverarbeitung im geeigneten Format bereitzustellen. Dabei werden unter anderem fehlende Werte interpoliert und ergänzt sowie etwaige Ausreißer identifiziert. Das Ergebnis ist eine bereinigte Datengrundlage – die Basis für eine nachhaltige Lösung.

- Data Mining greift auf Methoden aus Statistik und Informationstechnologie – wie das KDD („Knowledge Discovery in Databases“(KDD)-Verfahren – zurück, um aus vorhandenen Daten entscheidungsrelevante Informationen zu gewinnen. Eine erste Exploration lässt sich oft schon mit einer deskriptiven Analyse erreichen. Grafische Auswertungen in Form von Histogrammen, Scatterplots, Box-Plots oder Run-Charts geben Einblick in Abhängigkeiten, Einflussgrößen, Trends oder saisonale Schwankungen. Die Erkenntnisse der explorativen Studie werden dann durch quantitative Verfahren erweitert und vertieft. So helfen etwa Algorithmen des Unsupervised Learning, Muster in den Daten zu finden.

- Prescriptive Analytics bietet konkrete Antworten auf drängende Fragen. Cosmo Consult unterstützt Industrie-, Handels- und Serviceunternehmen mit intelligenten Analyse- und Optimierungsverfahren, um bei komplexen Fragestellungen die richtigen Entscheidungen zu treffen. Mit der Kombination von Predictive Analytics und Operations-Research entwickeln wir ganzheitliche Lösungsansätze im Bereich Prescriptive Analytics. Diese lassen sich wahlweise als Cloud-Service nutzen oder vor Ort in die vorhandene Systemlandschaft integrieren. So lässt sich ein globales Optimum berechnen, das alle bekannten Rahmenbedingungen und Einflussfaktoren berücksichtigt. Damit ändert sich der Betrachtungswinkel von „Was könnte passieren?“ hin zu „Was soll ich tun?“.

- Mit Predictive Analytics kann man aus Erfahrungen lernen. Der Forecaster von Cosmo Consult etwa ist ein intelligentes Prognosesystem, das die Qualität der Ergebnisse ständig überwacht und den mathematischen Algorithmus auf Basis neuester Erkenntnisse selbst korrigiert. Mit dem Forecaster lassen sich zentrale Charakteristika von Verbrauchszeitreihen wie Trends, Saisoneinflüsse oder Varianz systemseitig analysieren und bewerten. Zusätzlich ermittelt das Analysemodul den Einfluss externer Faktoren wie etwa Temperatur oder Wochentage.

Mit den Analyseergebnissen kann man anschließend das für die vorliegenden Daten optimale Prognoseverfahren ermitteln. Die Prognoseergebnisse werden entweder direkt im Unternehmen verwertet oder mit einem Operations-Research-Verfahren kombiniert, um optimierte Handlungsempfehlungen abzuleiten. Industrie-, Handels- und Dienstleistungsunternehmen sind so in der Lage, aus den Daten der Vergangenheit die richtigen Entscheidungen für die Zukunft zu treffen.

Machine Learning und künstliche Intelligenz schließlich führen zur datengetriebenen Prozessoptimierung. Erkannte Zusammenhänge aus dem Data Mining lassen sich durch Verfahren des Supervised Learning (Machine Learning) exakt quantifizieren und für Prognosen oder zur Optimierung von Entscheidungen nutzen. Verwendete, unterschiedliche Verfahren müssen eines gemeinsam haben: Sie müssen exakt auf die jeweilige Aufgabenstellung und die Situation des Unternehmens zugeschnitten sein.

„Ein professionelles Data Management vereinfacht, verwaltet und automatisiert die Integration der Daten – ganz gleich, ob sie aus internen oder externen Quellen stammen.“

Keine Theorie, sondern Praxis

Der Übergang auf solche datengetriebenen Prozesse ist für Unternehmen unerlässlich. Durch ihren Einsatz wird die Wettbewerbsfähigkeit und Nachhaltigkeit zielorientiert aufgebaut. Auf der Basis ihrer eigenen Daten bekommen Unternehmen „den optimalen Lösungsvorschlag“ für die jeweilige Entscheidungsfindung je nach Aufgabenstellung in wenigen Sekunden errechnet. Hierzu wurden parametrierbare, mathematische Modelle für eine Vielzahl von Fragen der Entscheidungsfindung erstellt. Diese Modelle werden den Anwendern aus entsprechenden Branchen oder IT-Partnern über den Einsatz von Microsoft Azure zugänglich gemacht. Je komplexer die Aufgabenstellung ist, desto größer ist das Einsparungspotenzial, das durch den Einsatz von mathematischen Modellen erzielt werden kann. (Siehe Kasten und Abb. 3.)

Optimierung des Produktionsnetzwerks

So geschehen in einem Projekt bei einem großen Hygienepapierhersteller, das eine Lösung zur simultanen Optimierung der Produktions-, Lager- und Transportplanung in einem europaweiten Produktionsnetzwerk liefern sollte. Nach einem gemeinsamen Assessment entwickelte man zunächst eine Softwarearchitektur, die im Wesentlichen aus einem Modul zur Aufbereitung der Daten und einem Optimierungs-Modul bestand und einer grafischen Oberfläche zur vereinfachten Nutzung der Optimierung und effizienten Datenverwaltung.

Basierend auf einem mathematischen Modell des Optimierungsproblems wurde ein Lösungsalgorithmus in C++ entwickelt, der für Teilprobleme die generischen Lösungsalgorithmen des IBM CPLEX-Solvers verwendet. Durch die komplexe Struktur des Problems wurde ein agiler Ansatz mit regelmäßigen Kundenfeedbacks und einem iterativen Entwicklungsprozess verfolgt, um sukzessive eine Optimierungslösung mit guter Akzeptanz zu erreichen. Im Rahmen der Optimierung waren die bei großen gemischt-ganzzahligen Problemen (MIPs) typischen langen Laufzeiten eine Herausforderung, die man durch Dekomposition des Problems und Separation der Nebenbedingungen auf Laufzeiten von 5 bis 10 Minuten pro Optimierungslauf reduzieren konnte.

Durch die simultane Optimierung aller relevanten Kostenarten ließ sich eine Gesamtkostenreduzierung in der Supply Chain erreichen. Mit der Überführung des Bauchgefühls der Mitarbeiter in digitales Wissen ließ sich zudem die Abhängigkeit von einzelnen Wissensträgern verringern. Die kurzen Laufzeiten und eine flexible Parametrisierung sorgen außerdem für kürzere Planungszyklen und schnellere Reaktionszeiten auf Veränderungen.

Optimierung der Software eines Leitsystems

In einem anderen Projekt zur Optimierung eines Staplerleitsystems suchte man eine Lösung für die optimale Zuweisung des Auftragspools auf die einzelnen Ressourcen unter Berücksichtigung bestimmter Kennzahlen. Das Ziel des Projekts bestand darin, die Fahraufträge aufgrund von Priorisierungen und Rahmenbedingungen so auf die einzelnen Ressourcen zu verteilen, dass alle kritischen Parameter eingehalten werden, aber gleichzeitig ein effizienter Ressourceneinsatz gewährleistet ist.

Nach einem Assessment mit dem Auftraggeber wurden zunächst die Anforderungen an die spätere Lösung sowie die notwendigen Schnittstellen, insbesondere an das ausführende SAP-System, definiert. Um die Zuteilung der Aufträge zu bewerten, entwickelte man ein künstliches Bestrafungssystem in C++, das insbesondere zu späte Auslieferungen pönalisiert und somit weitgehend verhindert. Dazu wurde zunächst eine Startheuristik formuliert, deren Güte mithilfe einer k-opt-Heuristik verbessert wurde. Via DLL und Java konnte man die Lösung anschließend vollständig in die bestehende Systemarchitektur integrieren.

Im Durchlauf werden zu jedem Zeitpunkt alle vorhandenen Fahraufträge in einem Pool optimiert und die Aufträge entsprechend verteilt. Somit ist sichergestellt, dass die einzelnen Ressourcen keinen starren, vordefinierten Plan verfolgen, sondern immer auf aktuelle Änderungen und Anfragen reagieren.

Verschiedene Kennzahlen wie Servicegrad und Auslastung der Ressourcen zeigen nun eine deutliche Verbesserung der Auftragsverteilung. Durch die ständige globale Optimierung haben leichte Eingriffe wie zusätzliche Aufträge oder der Wegfall von Fahraufträgen deutlich geringere Auswirkungen auf das System. Die Lösung bildet nun einen festen Bestandteil des Lösungsportfolios und wird von unserem Kunden aktiv bei verschiedenen Endkunden eingesetzt. //

| Der Text ist unter der Lizenz CC BY-SA 3.0 DE verfügbar. Lizenzbestimmungen: https://creativecommons.org/licenses/by-sa/3.0/de/ |

Handbuch Künstliche Intelligenz

Handbuch Künstliche Intelligenz Handbuch Digitalisierung

Handbuch Digitalisierung  Handbuch Handel mit Zukunft

Handbuch Handel mit Zukunft Handbuch HR-Management

Handbuch HR-Management Handbuch Digitalisierung

Handbuch Digitalisierung